Historia de la computadora (Máquinas, personajes precursores y generaciones) y dispositivos digitales

Hola amigos, el siguiente blog no es tan completo, pero ha de contener información interesante o útil...

Para empezar el blog, hablemos de:

La historia de la computadora (Junto a sus máquinas y precursores)

La computadora es en la actualidad una de las herramientas más usadas a nivel mundial por todo clase de usuarios. Estos dispositivos incluso realizan tareas que van más allá del objetivo de cuando fueron desarrolladas en su día.

En este sentido, una simple computadora puede ser utilizada tanto como para el simple entretenimiento y las redes sociales. Pero también la misma computadora puede controlar aspectos tan complicados como las misiones espaciales de forma completamente automática, tal es la variedad de trabajos en las que una computadora puede ayudar a la humanidad. Sin embargo, son pocas las personas que saben que estos dispositivos no nacieron con Windows.

Las computadoras ya llevan siglos entre nosotros, quizás en formas que nada tienen que ver con las actuales, pero no dejan de ser computadoras por ello.

Para estas necesidades, hace aproximadamente 4.000 a.C., se creó un aparato muy simple formado por una placa de arcilla donde se movían piedras que auxiliaban en los cálculos.

Ese aparato era llamado ábaco, una palabra de origen Fenicio. Ya para el año 200 a.C., el ábaco había cambiado, y estaba formado por una moldura rectangular de madera con varillas paralelas y piedras agujereadas que se deslizaban por estas varillas.

1614

John Napier (1550-1617) publicó un texto sobre el descubrimiento del logaritmo. Napier también inventó el sistema de Rods (referido como Rods de Napier o los huesos de Napier).

Esto hizo que fuera posible multiplicar, dividir, calcular la raíz cuadrada y cubica girando los rods, y colocándolos en placas especiales.

1623

Wilhelm Schickard (1592-1635), en Tuebingen, Wuerttemberg (ahora Alemania), Creó el "Reloj Calculador". Este instrumento era capaz de sumar y restar 6 dígitos, y en el caso de que el resultado sea mayor que 6 dígitos, tocaba una campana.

Las operaciones eran hechas mediante una manivela, que giraba y los números cambiaban, como en el contador K7 de los nuestro días.

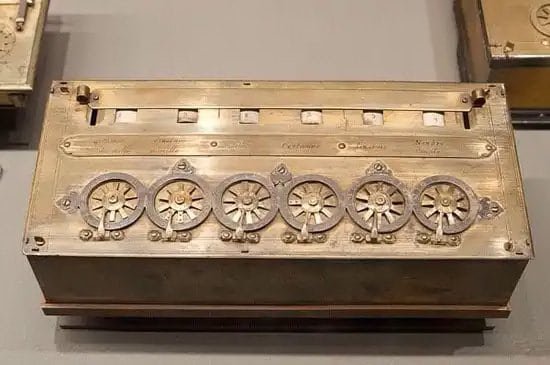

1642

El matemático francés Blaise Pascal construyó la máquina que sumaba (la “Pascalina”). A pesar de ser inferior al "Reloj Calculador" del Schickard (ver 1623), la máquina de Pascal se hizo más famosa.

El vendió docenas de ejemplares de la máquina en varias formas, logrando procesar hasta 8 dígitos.

1672

Después de muchas tentativas, finalmente es inventada en 1672 la primera máquina de calcular capaz de desarrollar las cuatro operaciones matemáticas (suma, resta, división y multiplicación) y además la raíz cuadrada.

Esa gran conquista fue atribuida al matemático Gottfried Wilhelm Von Leibnitz que mejoró la máquina de Pascal y obtuvo la calculadora universal.

1801

El telar automático era un telar con entrada de datos por medio de tarjetas perforadas para controlar la confección de tejidos y sus respectivos dibujos.

Fue creado en 1801 por Joseph Marie Jackuard y puede ser considerada la primera máquina mecánica programable de la historia.

1822

La Máquina Diferencial fue idealizada por el profesor y matemático de la Universidad de Cambridge, Charles Babbage, en 1822. Era un dispositivo mecánico basado en ruedas dentadas capaz de computar e imprimir extensas tablas científicas.

A pesar de tantas ventajas, esta máquina nunca llegó a ser construida a causa de las limitaciones tecnológicas de la época.

1834

George Scheutx, de Estocolmo, produjo una pequeña máquina de madera, después de leer una pequeña descripción del proyecto de Babbage.

1848

El Inglés matemático George Boole inventa el álgebra binaria booleana, abriendo el camino para el desarrollo de computadoras casi 100 años después.

1878

Ramón Verea, viviendo en Nueva York, inventa una calculadora con una tabla de multiplicación interna; es decir más fácil que girar engranajes u otros métodos.

El no estaba interesado en producirla, sólo quiso mostrar que los españoles podían inventar como los americanos.

1885

Una calculadora de multiplicación más compacta entra en producción masiva. La producción es más o menos simultánea con la invención de Frank S. Baldwin, de Estados Unidos, y T. Odhner, suizo viviendo en Rusia.

1890

En 1880 el censo realizado en los Estados Unidos llevó siete años para ser completado, ya que todos los cálculos fueron hechos a mano en papel de periódico. Por el aumento de la población se imaginó que el censo de 1890 llevaría más de 10 años.

Por este motivo, se realizó un concurso para hallar el mejor método para realizar el cómputo de los resultados.

Este concurso fue ganado por un empleado del Censo, Herman Hollerith, quien fundaría la Tabulating Machine Company, que luego se transformó en IBM. Herman tomó prestada la idea de Babbage de usar tarjetas perforadas (vea 1801) para hacer el sistema de memoria.

Con este método usado en 1890, el resultado (62.622.250 personas) estuvo listo en sólo 6 semanas. Con el sistema de memoria el análisis de los resultados fue muy fácil pero, a pesar de ser más eficiente, el costo del Censo de 1890 fue un 198% más costoso que el de 1880.

1941

Resultado de la 2da Guerra Mundial, la computadora Z3, construido por los alemanes, tenía como principal función la codificación de mensajes. Sin embargo fue destruida en Berlín dejándonos muy poca información sobre esta computadora.

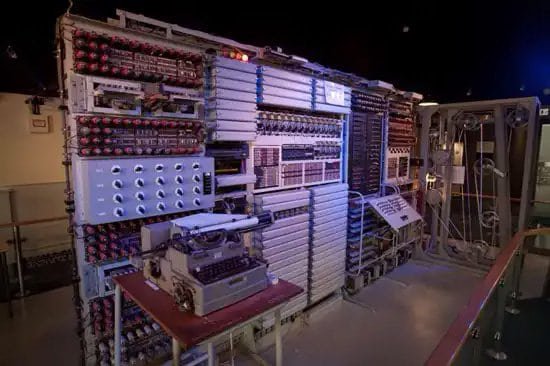

1943

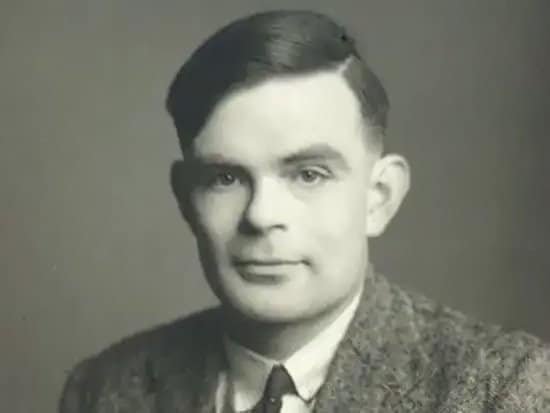

Así como los alemanes, los ingleses también fueron en búsqueda de tecnologías para descifrar códigos secretos construyendo entonces el Colossus (Servicio de Inteligencia Británico).

Poseyendo dimensiones gigantescas, Colossus funcionaba por medio de válvulas llegando a procesar cerca de 5 mil caracteres por segundo. Fue inventado por el matemático inglés Alan Turing.

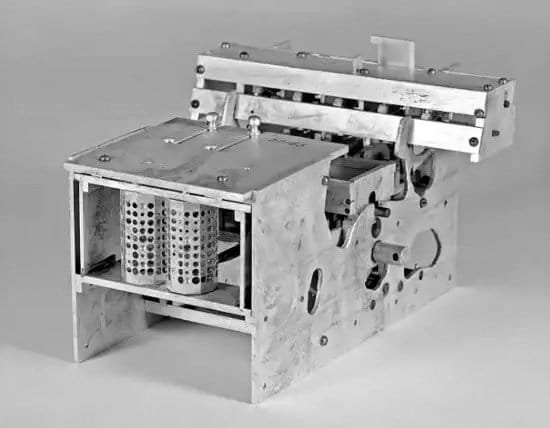

1944

Mark I (Howard Aiken) fue la primer computadora electromecánica construida. Bastante diferente de las computadoras actuales, Mark I medía 18 metros de largo, dos metros de ancho y pesaba 70 toneladas.

Estaba constituida por 7 millones de piezas móviles y su cableado alcanzaba los 800 Km. Con la llegada de las computadoras electrónicas Mark I fue inmediatamente sustituido.

1945

John Von Neumann, ingeniero matemático húngaro y naturalizado americano desarrolló un proyecto de computadora basado en la lógica, con almacenamiento electrónico de la información y de datos de programación.

La computadora procesaría los datos de acuerdo con las necesidades del usuario, o sea, las instrucciones no vendrían predeterminadas. Más tarde esa computadora fue construida recibiendo el nombre de Edvac.

El primer BUG de computadora fue relatado por la Oficial Naval y Matemática Grace Murray Hopper, el BUG era una polilla dentro de la computadora, la cual hizo que la computadora tuviera un desperfecto en sus cálculos. Cabe destacar que “Bug” en castellano se traduce como “bicho”.

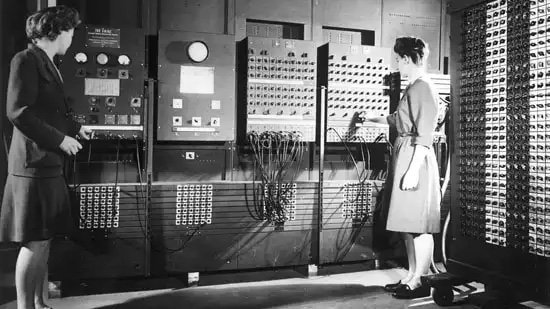

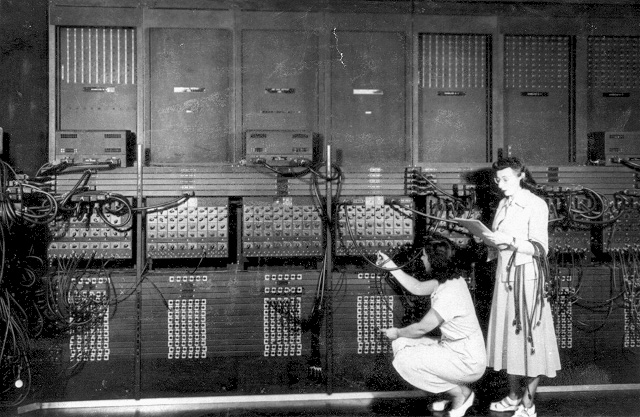

1946

John W. Mauchly y J. Prester Eckert Jr., junto con científicos de la Universidad de la Pensilvania, construyeron la primera computadora electrónica, conocido como ENIAC (Electronic Numerical Integrator and Calculator).

Esta computadora tenía aproximadamente 18 mil válvulas, pesaba 30 toneladas y llegaba a consumir 150 KW.

En contrapartida superaba mil veces la velocidad de las otras computadoras, llegando a realizar 5 mil operaciones por segundo.

1947

Presper Eckert y John Mauchly, pioneros en la historia de la computadora, fundaron la Cía. Eckert-Mauchly Computer Corporation. Esto fue con el objetivo de fabricar máquinas basadas en sus experiencias como el ENIAC y el EDVAC.

1948

La primera computadora comercial es inventada, llamada UNIVAC. John Bardeen, Walter Brattain y William Shockley de Bell Labs patentarían el primer transistor.

1949

Thomas Watson Jr. en una charla en un encuentro de ventas de IBM preanunció que todas las partes móviles en las computadoras serían sustituidas por componentes electrónicos en una década.

1951

El Univac fue la primera computadora comercializada. Proyectada por J. Presper Ecker y John Mauchly, ejecutaba 1905 operaciones por segundo y su precio llegó a US$ 1.000.000.

1952

Heinz Nixdorf fundó la Cía. Nixdorf Computer Corporation, en Alemania. Esta permaneció como una corporación independiente hasta su unión con Siemens, en 1990.

1953

La International Business Machines IBM lanza su primera computadora digital, la IBM 701. Como primera computadora de la marca comercializada, fueron vendidas 19 máquinas en tres años.

1954

El genio de las fórmulas matemáticas Alan Turing publicó el libro "On Computable Numbers" proponiendo cuestiones significativas sobre programación e inteligencia humana.

Utilizó sus aplicaciones de lógica en el desarrollo del concepto de máquina Universal. Texas Instruments anunció el inicio de la producción de los transistores.

1955

Anunciado por los laboratorios AT&T Bell, la Tradic fue el primer computador transistorizado, teniendo aproximadamente 800 transistores en el lugar de los antiguos tubos de vacío, lo que le permitía trabajar con menos de 100 Watts de consumo de energía.

1956

En el MIT (Massachussets Institute of Technology) investigadores comenzaron a probar la entrada de datos en teclados de computadoras. En el mismo lugar comenzaron las pruebas con la primera computadora con transistores (Transistorized Experimental Computer).

Cronología de la historia de la computadora: 1957-1981

1957

Un grupo de ingenieros liderados por Ken Olsen dejaron el laboratorio Lincoln del MIT y fundaron la Digital Equipment Corporation DEC.

Este año también fue creado un nuevo lenguaje: el Fortran, que permitía a la computadora ejecutar tareas repetidas a partir de un conjunto de instrucciones.

1958

Jack Kilby creó el primer circuito integrado en Texas Instruments para probar que resistores y capacitores podían existir en un mismo pedazo de material semiconductor. Su circuito era formado por una astilla de germanio y cinco componentes conectados por cables. La NEC de Japón construyó la primera computadora electrónica, el NEAC.

1959

La serie 7000 de mainframes IBM fue la primera de las computadoras transistorizadas de la compañía. En el tope de la línea de computadoras estaba el 7030, también conocido como STRETCH.

Siete computadoras, las cuales usaban palabras de 64 bits y otras innovaciones, fueron vendidas a laboratorios nacionales y otros usuarios científicos. L.R. Johnson fue el primero a usar el término "arquitectura" para describir el STRETCH.

1960

Fue diseñado el Dataphone, el primer módem comercial, específicamente para convertir señales digitales de computadora en señales analógicas para la transmisión a través de sus redes de larga distancia.

Un equipo liderado por varios fabricantes de computadoras y el Pentágono desarrollaron el COBOL, Common Business Oriented Language, el primer lenguaje volcado hacia el uso en programación de computadoras. IBM crea la primera fábrica masiva de transistores en Nueva York.

1961

Se crea el UNIMATE, primer robot industrial que entró en operación en la GM. Su función era apilar pedazos de metales calientes, labor que era ejecutada sin problemas.

1962

Los estudiantes del MIT Slug Russel, Shag Graetz y Alan Kotok escribieron el SpaceWar!, considerado el primer juego interactivo de computadora. El juego ofrecía gráficos interactivos que inspiraron los vídeos games futuros.

1963

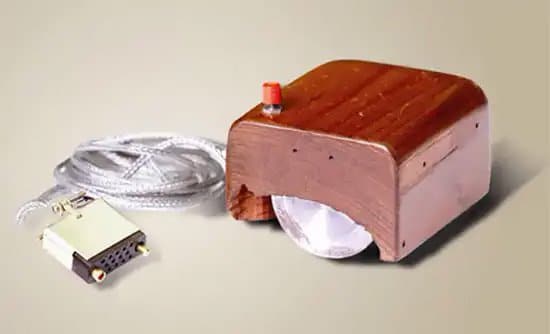

Se desarrolla el código ASCII (American Standard Code Information Interchange), el cual permitió que máquinas de diferentes fabricantes intercambiaran datos entre sí. La Digital Equipament vende la primera mini computadora. Douglas Engelbart recibe la patente del primer mouse para computadora.

1964

Thomas Kurtz y John Kemeny, profesores del DartMouth College, crearon el BASIC, un lenguaje de programación de fácil aprendizaje. También por aquella época se creó la computadora CDC 6600, diseñada por Seymour Cray.

Esta era capaz de ejecutar hasta 3 millones de operaciones por segundo y tenía velocidad de procesamiento tres veces mayor que la de su competidora.

Fue la más rápida hasta la llegada de su sucesora, en 1968, el CDC 7600.

1965

Gordon Moore dice que los circuitos integrados se van a duplicar en complejidad cada año.

1965

La DEC introdujo el PDP-8, la primera mini computadora comercializada con éxito. Era vendida a US$ 18 mil.

1966

Hewlett-Packard entró en el negocio de computadora para uso general con su HP-2115 ofreciendo un alto poder de procesamiento encontrado solamente en computadoras de gran porte.

Este dispositivo soportaba una gran variedad de lenguajes, entre ellas BASIC, ALGOL y FORTRAN.

IBM presenta el primer disco de almacenamiento, el IBM RAMAC 305.Tenía la capacidad de 5 MB.

1967

Seymour Papert diseñó el LOGO como un lenguaje de computación para niños. Inicialmente como un programa de dibujo. Este lenguaje de programación controlaba las acciones de una 'tortuga' mecánica, que trazaba su rastro en un papel. IBM construyó el primer floppy disk.

1968

Data General Corporation, compañía creada por un grupo de ingenieros que dejaron DEC, introdujeron la computadora NOVA. Con 32 KB de memoria, era vendida a US$ 8 mil.

La arquitectura simple del conjunto de instrucciones inspiró la Apple I, de Steve Wozniak, ocho años más tarde. Robert Noyce, Andy Grove y Gordon Moore fundan Intel.

1969

Programadores de los laboratorios AT&T Bell, Ken Thompson y Denis Richie desarrollan el UNIX, primer sistema operativo que podría ser aplicado en cualquier máquina. Ese año, el ejército americano conectó las máquinas de Arpanet, formando la red que originaría internet.

1970

El SRI Shakey fue el primer robot móvil internacional controlado por inteligencia artificial. Las protestas contra la guerra de Vietnam alcanzaron centros de computadoras de universidades y en la Universidad de Wisconsin, hirieron un hombre y dañaron cuatro computadoras

El Banco Nacional del Sur, en Valdosta, instaló la primera máquina electrónica de cajero automático para sus ciudadanos.

La primera comunicación computadora - computadora se desarrolló cuando el Departamento de Defensa Americano estableció cuatro puntos de comunicación en el ARPANET: Universidad de California-Santa Barbara, UCLA, SRI internacional, y Universidad de Utah.

1971

La Kenbak-1 fue la primera computadora personal anunciada por un científico americano, por 750 dólares. La primera propaganda de un microprocesador, el Intel 4004. Un equipo de IBM conducida por Alan Shugart inventó el disco flexible de 8".

1972

Lanzamiento del microprocesador Intel 8008. Hewlett-Packard, HP, anunció la HP-35 como "la más rápida y precisa calculadora electrónica" con una memoria de estado sólido similar a la de una computadora.

Steve Wozniak construyó el "Blue Box", un generador de tonos para atenciones de teléfono. Nolan Bushnell introdujo Pong y su nueva compañía, Atari vídeo games.

1973

Robert Metcalfe diseño Ethernet, método para la conexión en red, en el centro de investigación de Xerox en Palo Alto, California.

El TV Typewriter, desarrollado por Don Lancaster, proyectó el primer display de información alfanumérico en un estudio de TV común. La Micral fue la primera computadora comercial basada en un microprocesador, el Intel 8008.

1974

Los investigadores de Xerox, en el centro de investigación en Palo Alto, proyectaron el ALTO, la primera estación de trabajo con una entrada interna para mouse. Intel y Zilog introdujeron nuevos microprocesadores.

David Silver, del MIT, proyectó el brazo de plata. Este era un brazo mecánico para hacer ensamble de pequeñas piezas por medio del feedback de los sensores de toque y de presión en el robot.

Scelbi anunció la computadora 8H, la primera computadora comercial anunciada en Estados Unidos basada en el microprocesador Intel 8008.

1975

La edición de enero de The Popular Electronics anunció la computadora Altair 8800, basada en un microprocesador Intel 8080. Telenet, la primera red comercial, equivalente a ARPANET, fue instalada.

El prototipo del módulo de indicador visual (VDM), proyectado por Lee Felsenstein, marcó la primera ejecución de un indicador de video alfanumérico memory-mapped para computadoras personales.

La Tandem Computers lanzó la Tandem-16, la primer computadora fault-tolerant para transacción on-line de procesos. Es lanzada también la Imsai 8080 producida por IMS Associates, una computadora hecha con la misma estructura de BUS de la Altair 8800.

1976

Steve Wozniak proyectó la Apple I, la primer computadora single-board. Gary Kildall desarrolló el CP/M, un sistema operativo para computadoras personales.

1977

La Commodore PET (Personal Eletronic Transactor) fue la primera de muchas computadoras personales que surgieron este año. Apple II se hizo un éxito en su lanzamiento, en 1977, por sus características: circuito impreso en su placa madre, fuente de alimentación, teclado y cartuchos para juegos.

El primer mes después de su lanzamiento, la computadora personal Tandy Radio Shack's, la TRS-80, vendió el primer año 10 mil unidades, más que las 3 mil proyectadas por la compañía.

El gobierno de Estados Unidos adoptó el Standard de criptografía de datos de IBM, la llave para destrabar mensajes codificados, que sirven para proteger los datos confidenciales dentro de sus agencias.

También ese año fue lanzada la SOL, una computadora de fácil uso que sólo necesitaba de un monitor y eso atrajo mucha gente.

1978

La VAX 11/780, de la Digital Equipment Corporation, se caracterizó por ser una máquina capaz de procesar hasta 4.3 gigabytes de memoria virtual, probando ser la más rápida de las mini computadores de la época.

El disco flexible de 5" se transformó en la medida standard de software para computadoras personales, inmediatamente después de que Apple y Tandy Radio Shack's introdujeran sus softwares para este formato.

1979

El microprocesador 68000, de Motorola, se mostró mucho más veloz que los microprocesadores de la época. Los programadores Daniel Bricklin y Robert Frankston, de la Universidad Harvard, desarrollaron el VisiCalc, programa que transformó a las computadoras comerciales en computadoras personales.

Carver Mead, profesor del Instituto de Tecnología de California, y Lynn Conway, científica de Xerox Corporation, escribieron un manual sobre el proyecto de un chip, llamado "Introduction to VLSI Systems”.

1980

Seagate Technology desarrolló el primer Hard Disk Drive para micro computadoras. El disco almacenó 5 megabytes de datos, cinco veces más que la mayoría de los discos comunes de la época.

Desarrollado por Philips, el primer disco óptico de almacenamiento de datos tenía una capacidad de almacenamiento 60 veces mayor que un disco flexible de 5”.

John Shoch, del centro de investigación de Xerox, en Palo Alto, inventó la computadora "Worm" la cual traía un programa de alto desempeño para la búsqueda de información.

1981

IBM introdujo su PC, proporcionando rápido crecimiento del mercado de computadoras personales. El MS-DOS (Microsoft Disk Operating System) fue el software básico o sistema operativo lanzado para la PC de IBM, estableciendo una larga asociación entre IBM y Microsoft.

Adam Osborne desarrolló la primer computadora portátil, el Osborne I. Apollo Computer desarrolló la primera estación de trabajo, la DN100, con capacidad superior a la de muchos mini computadoras de precios similares.

Cronología de la historia de la computadora: 1982-2001

1982

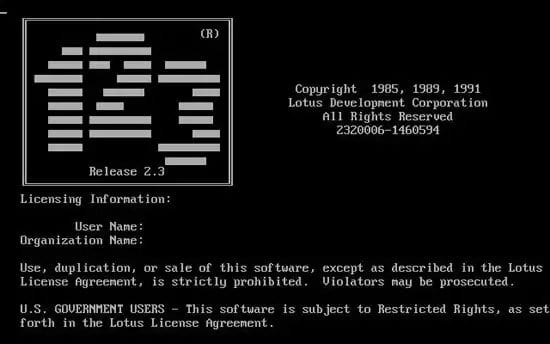

Mitch Kapor desarrolló el Lotus 1-2-3, software desarrollado para la computadora personal de IBM. La revista Time provocó euforia en su tradicional elección del "Hombre del Año" al seleccionar una computadora como la "Máquina del Año".

El uso de gráficos generados por computadoras para películas dio un gran paso a través de la realización de la película "Tron", lanzado por Disney.

1983

La primera computadora personal con interfaz gráfica es desarrollada por Apple. Compaq Computer Corporation introdujo su primera computadora personal (PC), que usaba el mismo software que la PC de IBM.

Microsoft anunció el procesador de textos Word, llamado anteriormente Multi-Tool Word. Además anunció el lanzamiento del sistema operativo Microsoft Windows.

El MIDI (Musical Instrument Digital Interfaz) es mostrado en la primera muestra North American Music Manufactures, en Los Angeles.

1984

Apple Computer Corporation lanzó el Macintosh, la primera computadora con mouse e interfaz gráfica, con un valor de US$ 1,5 millones de dólares. El diskette de 3 ", o " floppy", fue ampliamente aceptado por el mercado, ayudado por la decisión de Apple Computer de integrarlo en el nuevo Macintosh.

IBM lanzó la PC Jr y la PC-AT. La PC Jr. fracasó, pero la PC-AT, varias veces más rápido que la PC original y basado en la plataforma Intel 80286, se fue un éxito debido a su óptima performance y gran capacidad de almacenamiento, todos esos recursos por aproximadamente US$ 4 mil.

William Gibson, en su libro Neuromancer, inventó el término Cyberspace ó Ciber espacio.

1985

Internet avanzó otro gran paso cuando el National Science Foundation estructuró el NSFNET conectando cinco supercomputadores en las Universidades de Princeton, Pittsburgh, California, Illinois y Cornell.

Nace el CDROM. Con capacidad para almacenar 550Mb de información, los nuevos CD- ROMs expandieron el mercado de CDS de música. Aldus lanzó el programa PageMaker para el uso en computadoras Macintosh, mostrando su interés en Desktop Publishing.

Dos años más tarde, Aldus desarrolló la versión para IBMs y computadoras compatibles. El lenguaje de programación C++ surgió y dominó la industria de computadoras cuando Bjarne Stroustrup publicó el libro "The C++ Programming Language."

1986

David Miller, de AT&T Bell Labs, patentó el transistor óptico SEED (Self-ElectroOptic-Effect Device), un componente digital para computadoras.

Daniel Hillis, de la Thinking Machines Corporation, impulsó la inteligencia artificial cuando desarrolló el concepto compacto de conexión paralela. IBM y MIPS desarrollaron las primeras estaciones de trabajo PC/RT y R2000 basadas en RISC.

Compaq desbancó a IBM en el mercado cuando anunció el Deskpro 386, la primera computadora en el mercado a usar el nuevo procesador Intel 386.

1987

Motorola desarrolló el microprocesador 68030. IBM introdujo al mercado las computadoras PS/2, fabricadas con drives de 3”. William Atkinson, ingeniero de Apple, proyectó HyperCard, un software que simplificaba el desarrollo de aplicaciones domésticas.

1988

El Co-fundador de Apple, Steve Jobs, dejó Apple para fundar su propia compañía, NeXT. Compaq y otros fabricantes de PC desarrollaron EISA (Enhanced Industry Standart Architecture), una arquitectura standard.

“Pixar's Tin Toy" hizo la primera película realizada en computadoras que posteriormente ganara un premio Oscar de la Academia por mejor dibujo animado en cortometraje.

Robert Morris envió un virus a través de Internet, que causó problemas a aproximadamente un 10% de los 60 mil usuarios de la red.

1989

Intel lanzó el microprocesador 80486 y el i860 chip RISC/coprocesador, cada uno contiendo más de 1 millón de transistores. Motorola anunció el microprocesador 68040, con aproximadamente 1,2 millón transistores.

Maxis lanzó el SimCity, un juego de video game que utilizaba una serie de simuladores. La ciudad era usada frecuentemente en ambientes educativos. El concepto de la realidad virtual fue el tema principal en la convención de Siggraph's, realizada en Boston, Massachussets.

1990

Microsoft anunció Windows 3.0, el día 22 de mayo. Compatible con DOS, la primera versión de Windows ofrecía satisfacción y performance a los usuarios de PC. La World Wide Web nació cuando Tim Berners-Lee, un investigador del CERN, desarrolló el HTML (HiperText Markup Language).

1991

La Power PC de la alianza IBM, Motorola, y Apple es presentado en Julio. Investigaciones de Cray revelan el Cray Y-MP C90 con 16 procesadores y una velocidad de 16 Gflops.

1992

DEC presenta el primer chip a implementar la arquitectura RISC Alpha 64-bit. En marzo de 1992, se transmite por Internet el primer audio multicast M-Bone.

Después de generar una enorme preocupación en todos los usuarios de computadoras, el virus Michelangelo realiza un estrago de pequeñas proporciones.

1993

Apple presenta Newton, el primer PDA (personal digital assistant). El Pentium de Intel es presentado en marzo. La Universidad de Illinois desarrolla una interfaz gráfica para navegación por Internet llamada NCSA Mosaic.

1994

Leonard Adleman de la University of Southern California demuestra que el ADN puede ser un medio computacional. Jim Clark y Marc Andreesen fundan Netscape Communications (originalmente Mosaic Communications).

El primer navegador (browser) de Netscape se lanza y genera un rápido crecimiento de navegantes de la Web.

1995

Toy Story es el primer largometraje enteramente generado por computadora. Windows 95 es lanzado el 24 de agosto con una gran campaña de marketing.

El lenguaje de programación Java, lanzado en mayo, permite el desarrollo de aplicaciones independientes de plataformas. "Duke" es el primer applet.

1996

Es presentado el Pentium Pro de Intel. La IEEE Computer Society celebra sus 50 años.

1997

El Netscape Navigator 2.0 es lanzado. Fue el primer navegador (browser) con soporte para Javascript. Intel lanza el procesador Pentium de 150,166 & 200 MHz. Ellos tiene el equivalente a 3.3 millones de transistores.

La IBM Deep Blue, fue la primera computadora en ganarle al campeón mundial de ajedrez Gary Kasparov en un juego.

1998

Es lanzado el procesador Pentium II 333 MHz, más rápido que el antiguo. Microsoft lanza Windows 98.

1999

Linux es lanzado. El número de personas que usan LINUX es estimado en más de 10 millones.

2000

AMD lanza el AMD de 1GHz. Intel lanza una cantidad limitada del Pentium III. Es decretado el fin del TELEX. Es lanzado el Linux Kernel.

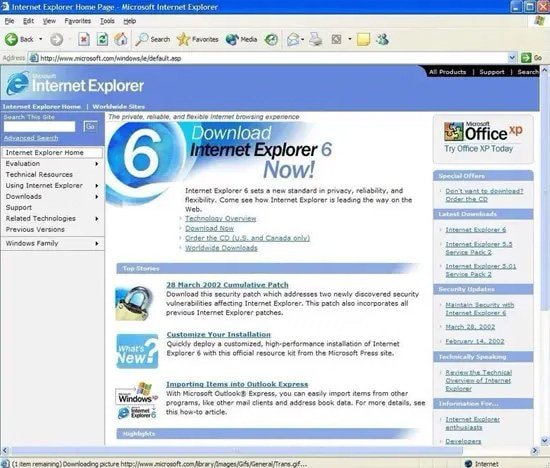

2001

Apple lanza al mercado el sistema operativo Mac OS X, el cual entre sus novedosas características incluye arquitectura de memoria protegida y multitarea preferencial.

El mismo año, Microsoft lanza al mercado el sistema operativo Windows XP, sin lugar a dudas, una verdadera revolución para el mercado de las PC.

2003

En este año, el fabricante AMD lanza al mercado de consumo el primer procesador de 64 bits, el Athlon 64 de AMD.

2004

La Fundación Mozilla lanza al mercado la primera versión del navegador Firefox, la 1.0, con la cual intenta competir con Microsoft Internet Explorer, el estándar de aquel momento.

También en el mismo año aparece Facebook, la red social que marcaría un antes y un después en cómo las personas se relacionan.

2005

En este año aparece en Internet YouTube, un servicio de hospedaje de video que luego sería comprado por Google y llevado a lo que conocemos hoy. También en ese año la misma firma compra Android, un proyecto muy avanzado de sistema operativo para celulares inteligentes.

2006

Aparece la primera MacBook Pro, la primera notebook con doble núcleo de Apple. El mismo año aparece también la consola Wii de Nintendo.

2007

Llega al mercado el iPhone, un smartphone que cambiará para siempre el modo de trabajar y de comunicarnos gracias a las características de avanzada que ofrece.

2008

En este año ocurre un hito tecnológico son precedentes, ya que la supercomputadora IBM Roadrunner es la primera en el mundo en superar el PetaFLOP de proceso.

2009

Sale al mercado la versión más popular y recordada de Windows, la número 7, que ofrecía múltiples características y opciones de avanzada muy enfocadas en la productividad. Además, se convertiría en una de las versiones más estables del sistema.

2011

Sale al mercado de consumo el iPad de Apple, un dispositivo formato tablet que establecería un nuevo modo para el consumo masivo de información. En el mismo año, la firma Google lanza al mercado su Chromebook, una notebook equipada con su propio sistema operativo.

2013

Salen al mercado Microsoft Windows 8.1 y Apple Mac OS X Mavericks.

2014

Ese año Apple Inc. Lanza al mercado su primer reloj inteligente, llamado “Apple Watch”.

2015

Microsoft lanza al mercado Windows 10, que se convertiría con el paso del tiempo en una de las mejores versiones del mismo, tanto por opciones y características como por estabilidad y rendimiento.

2016

En la Universidad de Maryland College Park se pone en funciones la primera computadora cuántico reprogramable.

2017

Se anuncia a los medios que la Agencia de Proyectos de Investigación Avanzada de Defensa (DARPA), la creadora de los inicios de Internet se encuentra desarrollando un programa llamada “Informática Molecular” que utiliza moléculas como computadoras.

2018

Apple lanza al mercado el iPhone Xs, iPhone Xs Max y el iPhone XR.

A principios de ese mismo año, se publica el conjunto de vulnerabilidades críticas de seguridad “Meltdown” y “Spectre” los cuales afectan entre los dos a la mayoría de los procesadores en el mercado.

2019

IBM presenta al mercado la primera computadora cuántica comercial, la IBM Q System One. Asimismo anuncia una computadora cuántica de 53 cúbits, un verdadero hito tecnológico.

2020

A pesar de la pandemia suscitada por el SARS Covid-19, los avances en el desarrollo de tecnología no se detuvieron.

Honeywell anuncia a los medios especializados el lanzamiento de una nueva computadora cuántica capaz de alcanzar un volumen cuántico de 64.

2021

En este año se intensifican los pagos por Internet y medios electrónicos de todo tipo. Ya prácticamente no se necesita dinero físico. Otra tecnología en pleno auge en este año en la VR.

También cambian muchas costumbres en el ámbito laboral. El 2021 nos ve trabajando desde cualquier lugar gracias a la nube.

Generaciones de computadoras y sus innovaciones

Primera generación: tubos de vacío (1940-1956)

Los primeros sistemas informáticos usaban tubos de vacío para los circuitos y tambores magnéticos para la memoria, estos equipos a menudo eran enormes, ocupando salas enteras. Además eran muy costosos de operar además de utilizar una gran cantidad de electricidad, los primeros ordenadores generaban mucho calor, que a menudo era la causa de un mal funcionamiento.

Los ordenadores de primera generación se basaban en el lenguaje de máquina, el lenguaje de programación de nivel más bajo, para realizar operaciones, y solo podían resolver un problema a la vez. A los operadores les tomaría días o incluso semanas establecer un nuevo problema. La entrada de los datos se basó en tarjetas perforadas y cinta de papel, y la salida se mostró en las impresiones.

UNIVAC y ENIAC son ejemplos de dispositivos informáticos de primera generación. El UNIVAC fue el primer ordenador comercial entregada a un cliente comercial, la Oficina del Censo de los Estados Unidos en 1951.

Segunda generación: transistores (1956-1963)

El mundo vería que los transistores reemplazan los tubos de vacío en la segunda generación de ordenadores. El transistor fue inventado en Bell Labs en 1947, pero no se vio un uso generalizado hasta finales de la década de 1950. El transistor era muy superior al tubo de vacío, lo que permitía que los ordenadores se volvieran más pequeños, más rápidos, más baratos, más eficientes energéticamente y más confiables que sus antecesores de primera generación. Aunque el transistor aún generaba una gran cantidad de calor, fue una gran mejora con respecto al tubo de vacío. Los ordenadores de segunda generación aún dependían de tarjetas perforadas para la entrada y copias impresas para la salida.

Estos equipos pasaron del lenguaje de máquinas binarias crípticas a lenguajes simbólicos o de ensamblaje, lo que permitió a los programadores especificar instrucciones en palabras. Los lenguajes de programación de alto nivel también se estaban desarrollando en este momento, como las primeras versiones de COBOL y FORTRAN. Estos fueron también los primeros ordenadores que almacenaron sus instrucciones en su memoria, que pasaron de un tambor magnético a una tecnología de núcleo magnético. Los primeros ordenadores de esta generación fueron desarrollados para la industria de la energía atómica.

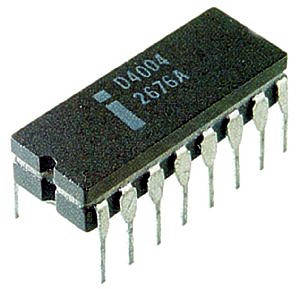

Tercera Generación: Circuitos Integrados (1964-1971)

El desarrollo del circuito integrado fue el sello distintivo de la tercera generación de ordenadores. Los transistores fueron miniaturizados y colocados en chips de silicio, llamados semiconductores, que aumentaron drásticamente la velocidad y la eficiencia.

En lugar de tarjetas perforadas e impresiones, los usuarios interactuaron a través de teclados y monitores, e interactuaron con un sistema operativo, lo que permitió que el dispositivo ejecutara muchas aplicaciones diferentes a la vez con un programa central que monitoreaba la memoria. Por primera vez se hicieron accesibles para una audiencia masiva, porque eran más pequeños y más baratos que sus predecesoras.

Cuarta generación: microprocesadores (1971-presente)

El microprocesador trajo la cuarta generación de ordenadores, ya que miles de circuitos integrados se construyeron en un solo chip de silicio. Lo que en la primera generación llenaba una habitación entera, ahora cabía en la palma de la mano. El chip Intel 4004, desarrollado en 1971, ubicó todos los componentes, desde la unidad de procesamiento central y la memoria hasta los controles de entrada / salida, en un solo chip.

En 1981, IBM presentó su primer ordenador para el usuario doméstico, y en 1984, Apple presentó el Macintosh. A medida que se volvieron más poderosos, pudieron vincularse entre sí para formar redes, lo que finalmente condujo al desarrollo de Internet. Los ordenadores de cuarta generación también vieron el desarrollo de GUI, el ratón y dispositivos de mano.

Quinta generación: inteligencia artificial (presente y más allá)

Los dispositivos informáticos de quinta generación, basados en inteligencia artificial, aún están en desarrollo, aunque hay algunas aplicaciones, como el reconocimiento de voz, que se están utilizando en la actualidad. El uso de procesamiento paralelo y superconductores está ayudando a hacer realidad la inteligencia artificial. La computación cuántica y la nanotecnología molecular cambiarán radicalmente la cara de las computadoras en los años venideros. El objetivo de la computación de quinta generación es desarrollar dispositivos que respondan al aporte del lenguaje natural y que sean capaces de aprender y autoorganizarse.

Y ya terminada la historia de la computadora hablaré sobre los dispositivos digitales.

¿Qué son los dispositivos digitales?

Los dispositivos digitales son los aparatos electrónicos que te facilitan las tareas y te ayudan en ciertas necesidades o simplemente para entretenerte.

Ya sea en el hogar o en el trabajo estos dispositivos pueden ayudarte a hacer bastantes cosas como limpiar mientras descansas, lo cual es bastante útil si trabajas y necesitas descansar.

Ejemplos de dispositivos digitales

Aquí algunos ejemplos de estos dispositivos:

- Televisión: Es una fuente de entretenimiento, información y comunicación. Sirve para relajarse, entretenerse o informarse de cosas que pasan en el mundo.

- Teléfono inteligente: Es una fuente de entretenimiento, información y trabajo.

- Computadora: Lo mismo que el teléfono, pero con la diferencia de poder hacer varias tareas al mismo tiempo y ser más versátil.

- Tablet: Lo mismo pero con una pantalla más amplia que el celular.

- Impresora digital: El propósito de este dispositivo es el de imprimir archivos directamente.

- Radio: Fuente de entretenimiento e información, solo se puede escuchar.

- Cámara digital: Este dispositivo sirve para tomar fotos o videos en formato digital, usualmente las cámaras digitales tienen mejor resolución y ajustes que las cámaras de un celular o computadora.

- Consola: Mayormente este dispositivo es usado por puro entretenimiento, pero no es 100% así, las consolas están diseñadas para videojuegos pero en el caso del Xbox One/Series X y S no solo sirve para eso, estas 3 consolas tienen Microsoft Edge, youtube, Netflix, HBO y otras funciones parecidas ya sea para estudiar o para entretenerse.

- Cafetera: Como su nombre lo indica, es para hacer y servir café.

- Peso digital: Es una balanza pero más precisa y fácil de utilizar.

Importancia de estos dispositivos

Además de saber qué es, resulta importante conocer para qué sirve la tecnología digital. Actualmente, la tecnología digital es utilizada para funciones como el procesamiento de grandes volúmenes de datos, la automatización de procesos, las comunicaciones masivas, la creación de sistemas que imitan al pensamiento humano, los cómputos sumamente potentes, entre otros.

Su amplia capacidad permite desarrollar un gran número de tareas en un tiempo reducido para simplificar las labores humanas en todos los ámbitos de la humanidad (domésticos, comerciales, industriales, educativos, médicos, etc.). Esto mediante la optimización de los sistemas y la aportación de soluciones efectivas a los problemas.

¿Para qué sirve la tecnología en la comunicación digital con los clientes?

Según Harvard Business Review, el 73% de los clientes realizan compras tanto en tiendas físicas como en digitales. Esto ha motivado a las empresas a desarrollar plataformas online, capaces de generar una comunicación efectiva con el mercado. Para lograrlo, implementan herramientas como páginas web, chatbots, asistentes virtuales, entre otros recursos tecnológicos.

De igual manera, las organizaciones con logística de entregas, suelen utilizar geolocalizadores capaces de informar a sus clientes el estatus de su pedido en tiempo real. Estos procesos, utilizados de forma conjunta, se han convertido en una práctica que favorece la experiencia del consumidor en todas las etapas de compra de un producto o servicio.

¿Para qué sirve la tecnología en la investigación, análisis y proyección?

Según el informe anual de la Sociedad Europea de Opinión e Investigación de Mercados (ESOMAR), hasta el 2018 la facturación en investigación de mercados cerró en 80.000 millones de dólares. También, enfatiza que la investigación mediante análisis de datos ha incrementado de manera favorable mientras que el uso de métodos los tradicionales, ha disminuido.

Definitivamente, la analítica de datos mediante herramientas como el big data y I.A. es la solución para las empresas que buscan resultados precisos, pero ¿para qué sirve la tecnología de investigación? Para la obtención de información, el diagnóstico, la toma de decisiones y la planificación de estrategias en las organizaciones.

Este tipo de investigación hace uso de tecnologías capaces de procesar grandes cantidades de datos en tiempo real. De esta forma, se pueden obtener insights de negocios relevantes sobre el estado actual de la organización e, incluso, es posible predecir elementos puntuales, como el comportamiento del mercado en una temporada determinada.

Países con más uso de tecnología en el mundo

Top ten "Economías orientadas a la innovación"

1. Suecia 7.95

2. Estados Unidos 7.77

3. Noruega 7.74

4. Dinamarca 7.54

5. Holanda 7.52

6. Finlandia 7.26

7. Australia 7.04

8. Reino Unido 7.03

9. Canadá 7.02

10. Japón 6.73

Top Ten de "Economías orientadas a la eficiencia y los recursos"

1. Malasia 7.14

2. Sudáfrica 6.18

3. Chile 6.06

4. Argentina 5.90

5. Rusia 5.82

6. Brasil 5.32

7. Turquía 5.09

8. México 5.00

9. Colombia 4.76

10. Ucrania 4.6

Peligros del avance tecnológico

El avance de nuevas tecnologías también trae riesgos al mundo, un ejemplo de esto es la creación de armas nucleares, al crear más tecnología contaminamos más y matamos más especies.

Otro riesgo es el hecho que grupos criminales pueden robar tecnología avanzada para crear más destrucción, por lo tanto es una hoja de doble filo, Estados Unidos podría crear una tecnología extremadamente avanzada para acabar con facciones terroristas/criminales, si embargo pueda ser que por un descuido o algún traidor las mismas facciones terroristas/criminales que buscaban detener con esa tecnología terminen usándola contra sus creadores.

Los recursos de la Tierra también pueden acabarse, ya sea por el mineral que requiere desarrollar una nueva tecnología, y mientras más se agoten los recursos naturales más países pelearán un objetivo común, la supervivencia, lo cual probablemente desataría varias guerras en el mundo, a menos que se utilicen los recursos restantes para fabricar un reemplazo.

La economía también puede ser dañada severamente por los altos costos de comprar materiales para tal tecnología, y al ser tan cara habría gente que no podría utilizarla por falta de recursos, lo cual aumentaría el costo de la tecnología por ser tan poco común.

Nota: No digo que esto podría pasar, no soy un experto, pero sí es una gran posibilidad viendo como estamos hoy en día.

Fuente de la imagenPara más información te recomiendo ver estos dos videos:

Dispositivos digitales | Introducción a los PLD's parte 1

Dispositivos digitales | Introducción a los PLD's parte 2

Y llegamos al fin de este blog, si tienes alguna recomendación puedes escribirla en los comentarios!!!

Comentarios

Publicar un comentario